Mettre en place une vraie architecture zero-copy

6min • Édité le 5 févr. 2026

Olivier Renard

Content & SEO Manager

[👉 Résumer cet article avec ChatGPT ou Perplexity]

La production de données numériques continue de progresser à grande vitesse. Cette année, le volume mondial devrait atteindre 221 zettaoctets (IDC / Statista), soit 27% de plus que l’an dernier.

Dans chaque entreprise, on utilise en moyenne 106 outils SaaS au quotidien (Bettercloud). La donnée transite entre de nombreux outils, les copies se multiplient et la gouvernance devient plus complexe.

Ces enjeux incitent les organisations à repenser la façon dont leurs données circulent et à moderniser leur stack data.

Les informations à retenir :

Le zero-copy consiste à exploiter la donnée sans la recopier. On retrouve ce concept en programmation informatique comme en data architecture.

Dans une stack data, le principe vise à éviter toute duplication entre outils et systèmes.

Cette approche a un impact direct sur la gouvernance, les coûts, la fraîcheur des données et la performance des activations.

Pour une CDP, cela signifie s’appuyer sur l’entrepôt ou le data lake comme référentiel. Le modèle warehouse-native se distingue des promesses des CDP traditionnelles autour du “no-copy”.

👉 Qu’est-ce que la zero-copy architecture et pourquoi suscite-t-elle autant d’intérêt ? Découvrez les fondamentaux et les applications concrètes de cette approche. 🔍

Qu’est-ce qu’une architecture zero-copy ?

Une architecture zero-copy exploite les données là où elles sont stockées, sans duplication.

Les outils viennent les utiliser à partir d’une source unique de vérité, sans les recopier dans leur propre base.

Dans le domaine informatique, le zero-copy décrit des mécanismes d’optimisation mémoire. Pour une Modern Data Stack, il renvoie à un principe d’architecture : amener les usages à la donnée, plutôt que déplacer la donnée vers chaque usage.

Concrètement, les données restent dans un socle central, le plus souvent le data warehouse cloud. Les outils d’analytics, d’activation ou les applications y accèdent directement, sans créer de copie dans leur système.

Différence avec les architectures traditionnelles

Les architectures data classiques reposent encore largement sur un modèle “copy to serve”. Les données sont copiées lors de l’ingestion, des transformations, ou durant leur utilisation dans les applications métier (outils de BI, plateformes marketing etc).

Cette logique entraîne des coûts de stockage plus élevés, de la latence, des divergences de vérité entre systèmes, et une dette d’intégration croissante.

Duplication de la source de vérité

Cas d’usage

Analytics & BI : les équipes analysent les données directement depuis l’entrepôt, sans exporter vers des bases intermédiaires.

Activation omnicanale : les segments et audiences s’appuient sur les données warehouse, puis sont activés vers les canaux marketing.

Personnalisation temps réel : les applications consomment les données à jour pour adapter les messages, contenus ou offres.

Partage de données partenaires : les données peuvent être mises à disposition d’acteurs externes via des mécanismes de partage (ex. data clean rooms), sans duplication physique.

Ces cas illustrent un même principe : simplifier les flux et rapprocher les usages de la donnée, sans multiplier les copies.

Principe et mise en place dans une Modern Data Stack

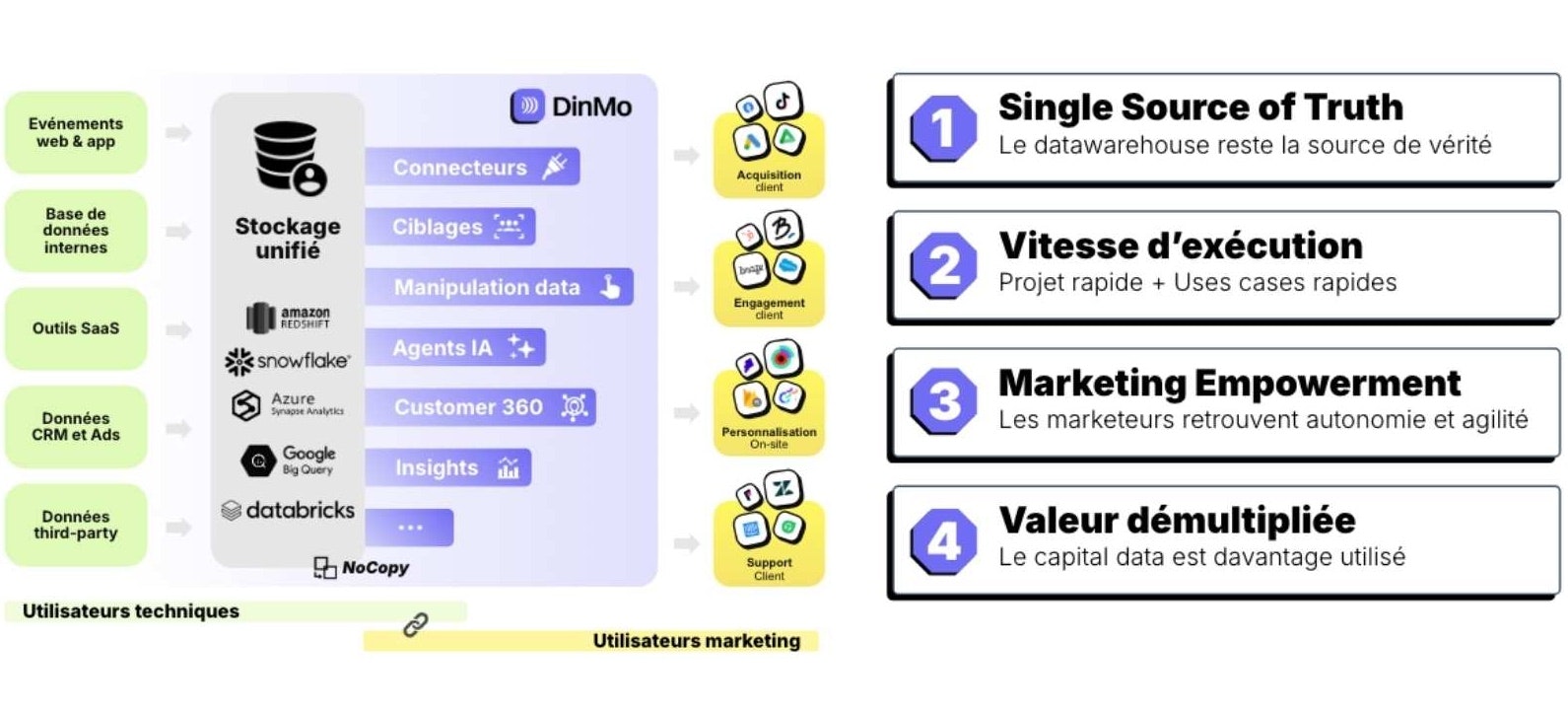

Une architecture zero-copy repose sur l’idée que les données restent dans un référentiel central, et que les usages viennent à la donnée. Dans une Modern Data Stack, ce socle est un data warehouse cloud. Il concentre les données clients, produits, transactionnelles et comportementales.

Les outils de la stack (analytics, marketing, applications, data science) ne créent pas chacun leur propre base. Ils s’appuient sur l’entrepôt pour lire et utiliser les données.

La stack est conçue pour acc�éder aux données à la source et interroger les tables existantes. Les principaux mécanismes qui entrent en jeu : data sharing, tables externes / vues, requêtes fédérées, etc.

D’un point de vue métier, cela limite les divergences entre les systèmes. Les définitions métier sont partagées : ce qui est visible dans la BI correspond à ce qui est utilisé pour l’activation.

Exploiter les données et l'IA dans les outils marketing au quotidien

Avantages et limites

Parmi les principaux avantages :

Des données plus fraîches et mieux sécurisées.

Une gouvernance simplifiée et une meilleure conformité.

Un time-to-value plus rapide.

Moins de pipelines d’intégration.

Quelques limites à connaître :

Plus de dépendance au moteur de calcul.

Potentiellement une légère latence dans certains cas d’usage spécifiques.

Certaines situations nécessitent encore une copie (ex. outils legacy).

Quand privilégier une architecture zero-copy ?

Une architecture zero-copy est particulièrement adaptée quand les usages se multiplient, de l’analytics à l’activation marketing, en passant par le scoring et le partage de données. Elle est appréciée des organisations soumises à de fortes contraintes de sécurité ou de conformité.

Ce type d’infrastructure vise avant tout à simplifier les flux de données et à réduire la multiplication des silos.

Zero-copy architecture et données clients

Les données clients ont des caractéristiques spécifiques. Volumineuses et évolutives par nature, elles sont utilisées par différentes équipes et soumises à des réglementations particulières.

Pour créer de la valeur, les entreprises doivent unifier leurs données clients puis les segmenter finement afin de les activer sur plusieurs canaux et mesurer la performance.

Dans une Modern data Stack, ces usages reposent sur le data warehouse. Un accès direct permet de travailler sur les données clients là où elles résident, sans multiplier les bases.

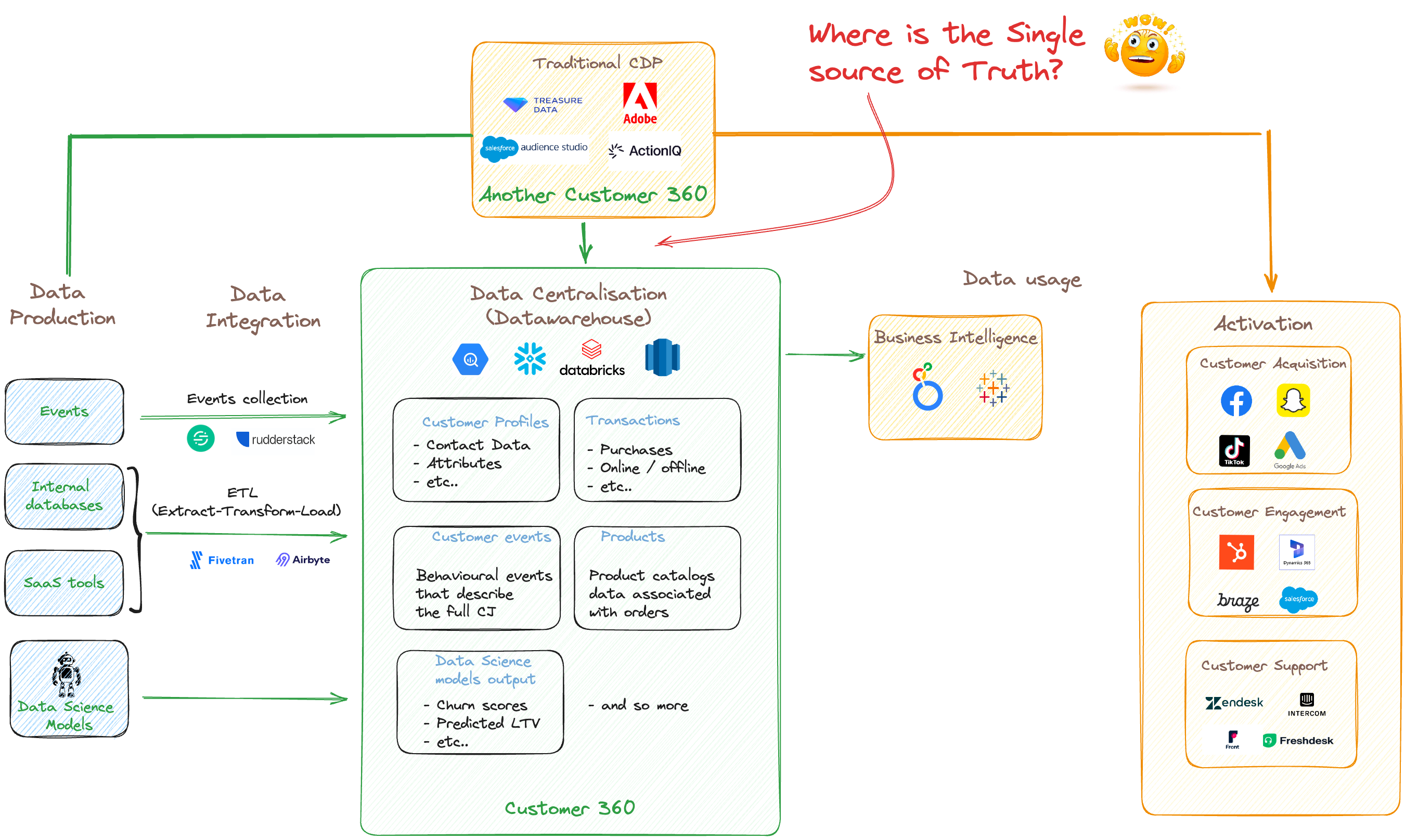

CDP composable : au-delà du marketing autour du “no-copy”

De nombreuses CDP historiques issues de l’écosystème MarTech communiquent aujourd’hui sur le “no-copy”.

Dans les faits, cela signifie généralement :

Une connexion au data warehouse,

La sélection de certains profils et attributs clés,

Puis une réplication dans leur propre base.

Autrement dit, le warehouse alimente un modèle interne propriétaire. Une copie partielle des données est maintenue côté éditeur.

Cette approche impose un modèle de données et nécessite de maintenir des mappings dans le temps. Elle repose sur un stockage parallèle et renforce le risque de vendor lock-in.

L’approche composable, ou le zero-copy by design

Une CDP composable warehouse-native adopte une logique différente. Elle s’appuie sur le data warehouse de l’entreprise, sans stocker de données chez l’éditeur ni imposer un modèle prédéfini.

Les calculs s’exécutent dans l’entrepôt, et les segments, scores et logs d’activation y sont également enregistrés. Le data warehouse devient l’unique référence : la BI correspond à ce qui est utilisé pour l’activation.

Cette approche évite de créer une seconde source de vérité. Pas de divergence entre outils : les équipes travaillent sur les mêmes tables et les mêmes règles.

Critère | Composable (warehouse-native) | “No-copy” (CDP traditionnelles) |

|---|---|---|

Stockage éditeur | ✅ Aucun | Stockage chez l’éditeur (profils / attributs répliqués) |

Modèle de données | Non imposé ; lecture du modèle client | ⚠️ Imposé ; mapping vers schéma propriétaire |

Source de vérité | Unique (DWH) ; BI ↔ Activation | ⚠️ Double (DWH → store éditeur) ; risques d’écarts |

Gouvernance & RGPD | Périmètre réduit (pas de réplication tiers) | Périmètre élargi (2 bases à gouverner). Réplication de PII chez un tiers. |

Performance | Calcul dans le DWH (élasticité, MPP) | Re-matérialisations, index, caches chez l’éditeur |

Time-to-value | ✅ Rapide ; pas de remapping forcé | ⚠️ Latences liées aux batchs, remappings récurrents (dette d'intégration) |

Coûts | DWH only (pay-as-you-go) | DWH + stockage / compute éditeur |

Évolutivité | ✅ Libre (nouvelles tables / champs sans friction) | Dépend du schéma éditeur (frictions à chaque évolution) |

En d’autres termes, une architecture zero-copy appliquée aux données clients ne consiste pas à copier moins. Il s’agit d’aligner BI, data et activation marketing autour du data warehouse, sans recréer une base client parallèle.

Conclusion

Plus qu’un slogan marketing, le zero-copy est avant tout un choix d’architecture. Il vise à faire circuler la donnée plus simplement dans la stack, sans recréer une source de vérité parallèle.

La tendance est aux écosystèmes ouverts et warehouse-centric. Les systèmes composables se généralisent, portés par l’adoption croissante des data warehouses cloud.

👉 Découvrez comment DinMo s’intègre à votre stack data pour lancer vos premiers cas d’usage en moins d’une heure.

FAQ

Zero-copy et performance : quid des temps de traitement ?

Zero-copy et performance : quid des temps de traitement ?

Dans une approche “no-copy”, on observe souvent des latences batch (horaires ou quotidiennes). Elles viennent des pipelines de synchronisation et des re-matérialisations nécessaires pour alimenter le store interne.

En composable, le data warehouse reste le moteur : moins de frictions, plus de fraîcheur, et des résultats plus proches du temps réel selon vos usages.

Peut-on mixer les deux approches ?

Peut-on mixer les deux approches ?

Techniquement, oui. Mais vous réintroduisez vite les limites du “no-copy” : une double vérité, plus de coûts, et davantage de latence liée aux synchronisations.

L’intérêt d’une approche composable est justement d’éviter cette duplication structurelle et de garder une infrastructure plus simple à opérer dans le temps.

Zero-copy et RGPD : quels bénéfices ?

Zero-copy et RGPD : quels bénéfices ?

Le vrai zero-copy favorise la conformité vis-à-vis des réglementations. Les données personnelles restent dans le data warehouse, ce qui simplifie la gouvernance, les droits d’accès et les processus de suppression.

Cela limite aussi la réplication de PII dans les outils tiers, et facilite la conformité aux exigences RGPD.